Probador de Robots.txt, Verificar el Buen Rastreo por Google

Tutoriales

Tutoriales

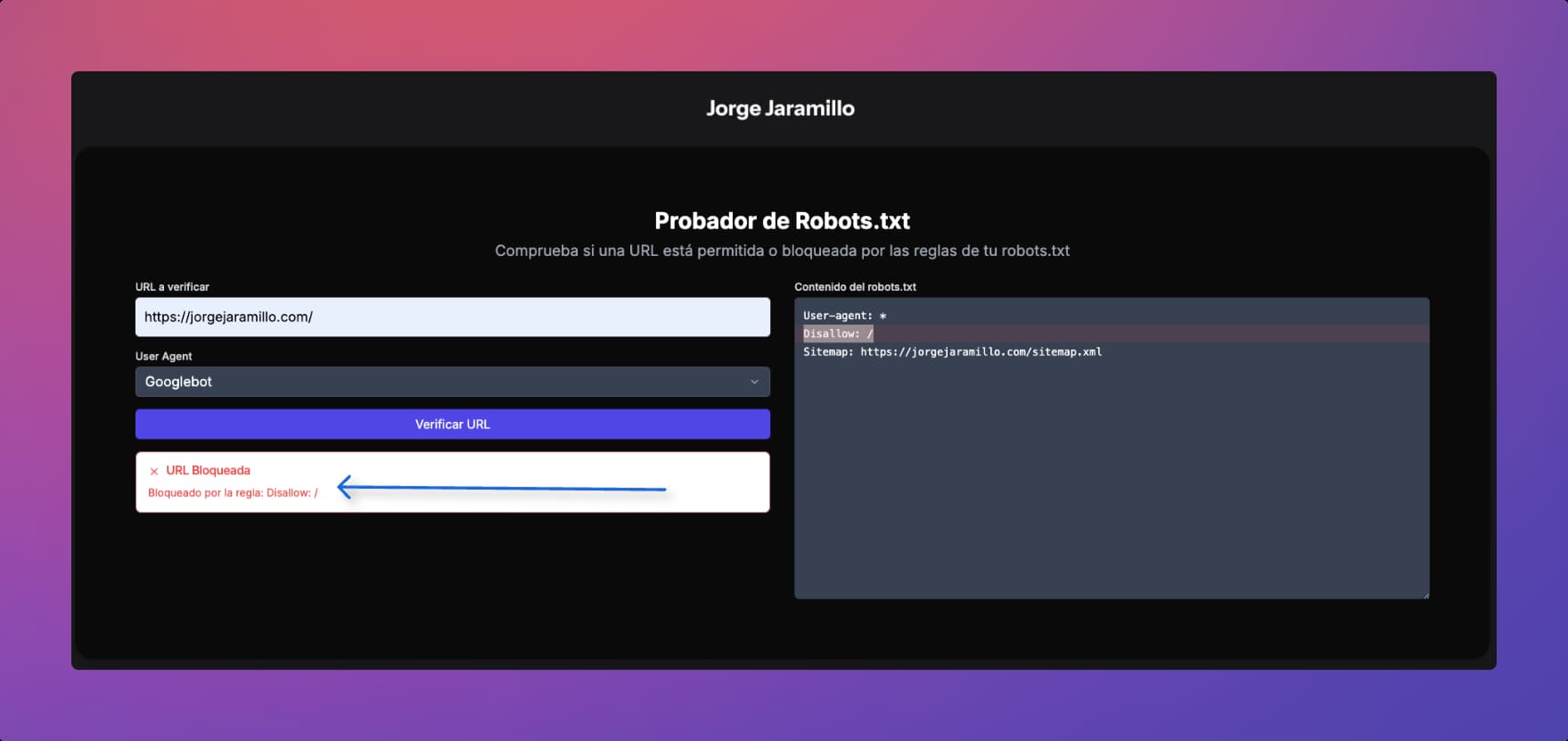

¿Quieres probar tu robots txt? Te enseño como hacerlo con esta herramienta propia.

Probador de robots.txt

El Probador de Robots.txt es una herramienta en línea gratuita diseñada para webmasters, desarrolladores y profesionales SEO. Esta aplicación permite a los usuarios validar y analizar las reglas de sus archivos robots.txt de manera rápida y eficiente.

Características principales:

1. Validación de URL: Comprueba si una URL específica está permitida o bloqueada según las reglas del robots.txt.

2. Selección de User Agent: Permite elegir entre varios user agents comunes, incluyendo Googlebot, Googlebot-Image, Googlebot-News, Bingbot, y una opción para todos los robots.

3. Visualización de reglas: Muestra el contenido del robots.txt en un formato fácil de leer, con resaltado de sintaxis.

4. Resaltado de reglas bloqueantes: Cuando una URL está bloqueada, la aplicación resalta visualmente la regla específica que causa el bloqueo.

5. Explicaciones detalladas: Proporciona razones claras sobre por qué una URL está permitida o bloqueada.

6. Interfaz intuitiva: Diseño limpio y responsive que facilita su uso en diferentes dispositivos.

7. Recursos educativos: Incluye ejemplos de robots.txt y respuestas a preguntas frecuentes para ayudar a los usuarios a entender mejor cómo funcionan las reglas de robots.txt.

Hice esta herramienta y voy a estar agregándole detalles que publicaré acá.

Esta herramienta es esencial para optimizar la indexación de sitios web, asegurando que los motores de búsqueda puedan acceder al contenido deseado mientras se protegen áreas sensibles del sitio.

Es ideal para quienes buscan mejorar su SEO y gestionar eficazmente el rastreo de sus sitios web.

Probador de robots.txt

En este vídeo miraremos la característica de probador de robots.txt en la herramienta de Google Search console.

Esta herramienta todavía pertenece a la versión anterior de Google Search console y aún no se conoce una fecha para pasar a la actual versión.

Estos son algunos de los temas que veremos en este video:

– Miraremos Cómo usar el probador de robots.txt

– Podemos hacer pruebas dentro del archivo luego descargarlo y subirlo posteriormente a nuestro sitio así verificarlo antes de tenerlo en producción.

– Este archivo nos sirve para bloquear diferentes Robots de otros sistemas no solo en Google

– Les voy a dejar documentación al respecto de los robots juntos en la descripción del video

TIP: Antes de subir el archivo robots.txt, probemos varias veces con diferentes URLs. Un error en este archivo puede bloquear a Google y acabar con nuestra estrategia de SEO